Deine Conversion Rate zu optimieren ist der direkteste Weg, um aus dem Traffic, den Du bereits hast, mehr Umsatz herauszuholen – ganz ohne Dein Marketingbudget anzufassen. Es geht im Kern darum, das Erlebnis für Deine Besucher so reibungslos und überzeugend zu gestalten, dass sie ganz von selbst die gewünschte Handlung ausführen. Ob das nun ein Kauf, eine Newsletter-Anmeldung oder ein Software-Trial ist.

Gerade wenn Du digitale Produkte wie Online-Kurse, E-Books oder eine SaaS-Lösung wie alfima.io anbietest, ist dieser Hebel Gold wert. Hier können schon winzige Anpassungen einen riesigen Unterschied machen und direkt zu mehr Kunden führen.

Warum Conversion-Rate-Optimierung so entscheidend ist

Stell es Dir einmal so vor: Du steckst jeden Monat einen festen Betrag in Werbeanzeigen, um Besucher auf Deine Seite zu locken. Anstatt dieses Budget immer weiter hochzuschrauben, um mehr und mehr Leute zu erreichen, konzentrierst Du Dich bei der Conversion-Rate-Optimierung (CRO) darauf, die Besucher, die schon da sind, besser zu überzeugen. Du schraubst also nicht an der Quantität des Traffics, sondern an der Qualität der Interaktionen, die auf Deiner Seite stattfinden.

Für jeden, der digitale Produkte wie E-Books, Online-Kurse oder Software-Abos verkauft, steckt hier ein enormes Potenzial. Manchmal reicht schon eine kleine Änderung an der Überschrift Deiner Landingpage oder am Text Deines Call-to-Action-Buttons, um die Anmeldungen für Deine Software-Demo oder die Verkäufe Deines neuen Guides zu verdoppeln.

Der Schlüssel zum Erfolg ist, Entscheidungen auf Basis von echten Daten zu treffen, statt sich nur auf das Bauchgefühl zu verlassen. Du verwandelst Nutzerfeedback und Verhaltensdaten in konkrete, messbare Verbesserungen.

Der Hebel für nachhaltiges Wachstum

Eine durchdachte CRO-Strategie ist kein einmaliges Projekt, das man abhakt. Sieh es eher als einen fortlaufenden Kreislauf aus Analysieren, Hypothesen aufstellen, Testen und Lernen. Gerade im digitalen Geschäft, wo der Wettbewerb nur einen Klick entfernt ist, ist es ein massiver Vorteil, seine Nutzer wirklich zu verstehen.

Aktuelle Zahlen zeigen, wie viel Potenzial hier oft auf der Straße liegt. Im deutschen E-Commerce beträgt die durchschnittliche Conversion Rate bei kleineren und mittleren Online-Shops gerade einmal 2,01 %. Das heißt im Klartext: Von 100 Besuchern kaufen im Schnitt nur zwei. Diese Statistik macht deutlich, wie wichtig es ist, die restlichen 98 Besucher besser zu verstehen und die Hürden aus dem Weg zu räumen, die sie vom Kauf abhalten. Mehr spannende Einblicke dazu findest Du in den Conversion-Rate-Statistiken im E-Commerce bei uptain.de.

Dieser Leitfaden nimmt Dich an die Hand und führt Dich durch einen praxiserprobten Prozess. Wir zeigen Dir, wie Du systematisch vorgehst – von der Analyse des Nutzerverhaltens bis zum erfolgreichen A/B-Test. Dabei helfen Werkzeuge, wie sie beispielsweise in einer All-in-One-Plattform wie alfima.io gebündelt sind. So kannst Du die Theorie direkt in die Praxis umsetzen und Deine Conversion Rate nachhaltig steigern.

Verstehen, wo Deine Nutzer wirklich abspringen

Jede nachhaltige Conversion-Optimierung beginnt mit einem ehrlichen Blick auf den Ist-Zustand. Viele Marketer und Creator wissen aber oft gar nicht, wo sie ansetzen sollen. Sie sehen vielleicht eine hohe Absprungrate in ihren Analysen, doch die nackte Zahl verrät nicht, warum die Nutzer die Seite verlassen. Genau hier müssen wir ansetzen.

Statt im Dunkeln zu tappen, musst Du zum Detektiv werden und das Verhalten Deiner Besucher entschlüsseln. Es geht darum, datengestützte Antworten auf die entscheidende Frage zu finden: An welcher Stelle im Prozess verlieren wir potenzielle Kunden und was sind die Gründe dafür?

Zahlen und Verhalten zusammenbringen: Das "Was" und das "Warum"

Der erste Schritt ist immer, die richtigen Daten zu sammeln. Hierbei unterscheiden wir zwischen zwei Arten von Informationen, die erst zusammen ein klares Bild ergeben:

- Quantitative Daten (Das "Was"): Das sind die harten Zahlen. Wie viele Besucher verlassen die Seite? An welchem Punkt im Funnel brechen die meisten Nutzer ab? Diese Daten bekommst Du aus klassischen Web-Analyse-Tools und sie zeigen Dir, was auf Deiner Seite passiert.

- Qualitative Daten (Das "Warum"): Hier geht es um das tiefere Verständnis. Warum klicken Nutzer auf ein bestimmtes Element, aber nicht auf den Kaufen-Button? Was genau sorgt für Verwirrung? Solche Einblicke gewinnst Du durch visuelle Analysen des Nutzerverhaltens.

Moderne Plattformen wie alfima.io haben den Vorteil, dass sie diese Werkzeuge direkt integrieren. So musst Du nicht ständig zwischen verschiedenen Systemen hin- und herspringen, sondern kannst nahtlos von der reinen Zahl zur visuellen Analyse wechseln.

Stellen wir uns ein typisches Szenario vor: Du verkaufst einen Online-Kurs über Deinen alfima.io Shop. Deine Analysedaten zeigen, dass 70 % der Nutzer den Checkout-Prozess abbrechen, sobald sie eine Zahlungsmethode auswählen sollen. Das ist eine wichtige quantitative Erkenntnis, aber sie bleibt abstrakt.

Das Nutzerverhalten sichtbar machen

Jetzt kommen qualitative Werkzeuge wie Heatmaps und Session-Recordings ins Spiel. Hier wird das Abstrakte endlich greifbar.

- Heatmaps visualisieren, wohin die meisten Nutzer klicken, wie weit sie scrollen und welche Bereiche Deiner Seite die meiste Aufmerksamkeit bekommen. Du siehst auf einen Blick, ob Dein wichtigster Call-to-Action überhaupt wahrgenommen wird.

- Session-Recordings gehen noch einen Schritt weiter. Sie zeichnen anonymisierte Sitzungen einzelner Nutzer auf. Du schaust quasi live über die Schulter und siehst, wie ein Besucher mit Deiner Seite interagiert – wo er zögert, verwirrt mit der Maus umherfährt oder frustriert aufgibt.

In unserem Online-Kurs-Beispiel könntest Du durch Session-Recordings entdecken, dass viele Nutzer bei der Zahlungsauswahl auf und ab scrollen. Der Grund? Sie sind verunsichert, weil irgendwo das Thema Versandkosten auftaucht – obwohl es sich um ein digitales Produkt handelt. Diese kleine Verwirrung führt zum Abbruch. Ohne diese visuelle Analyse hättest Du die Ursache vielleicht nie gefunden.

Indem Du quantitative Daten (70 % Abbruchrate) mit qualitativen Einblicken (Nutzer sind wegen Versandkosten verwirrt) kombinierst, schaffst Du eine solide Grundlage für eine zielgerichtete Hypothese. Das ist der Kern jeder erfolgreichen CRO-Maßnahme.

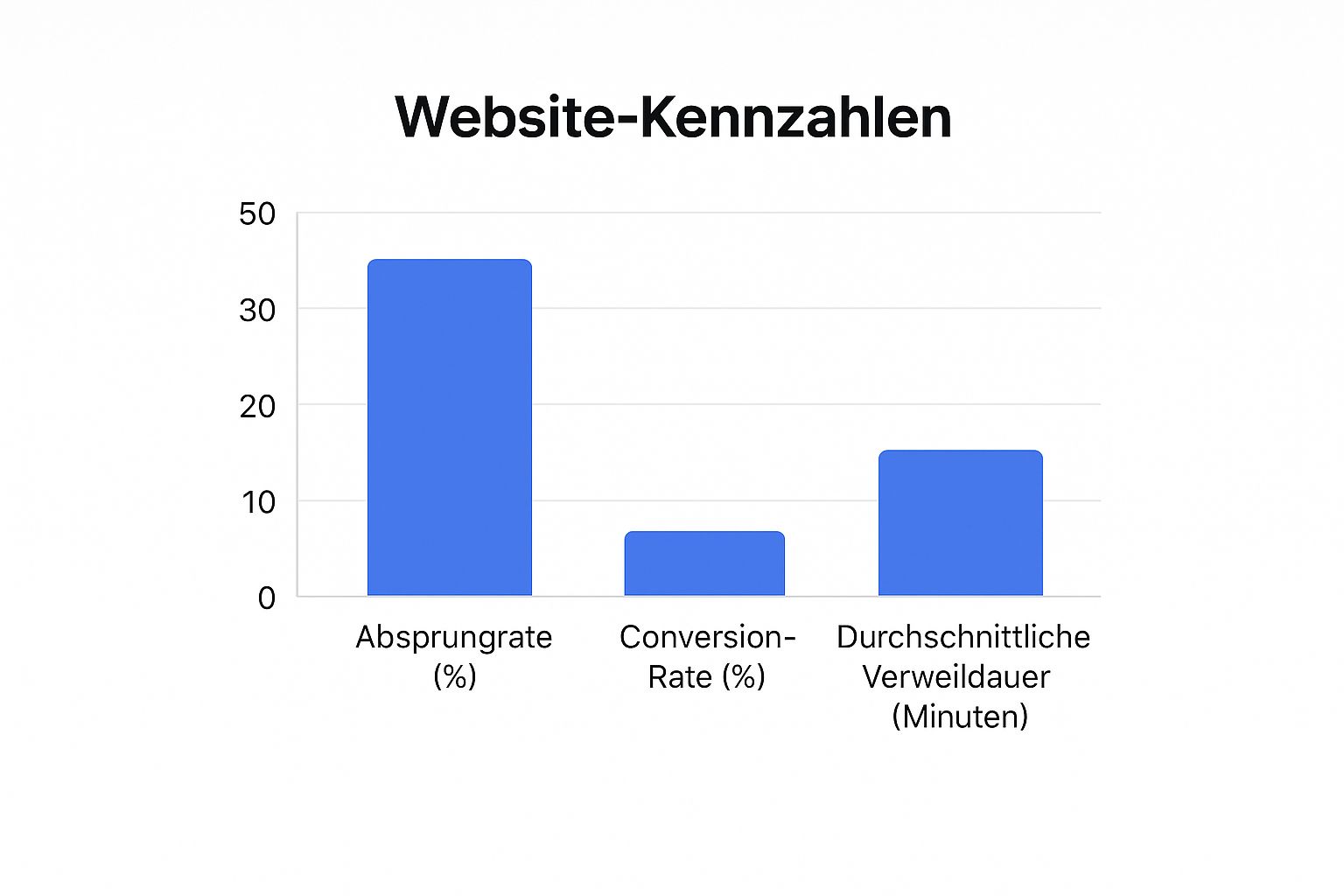

Die folgende Infografik verdeutlicht, wie eng Absprungrate, Conversion-Rate und Verweildauer miteinander verknüpft sind.

Man erkennt deutlich: Eine hohe Absprungrate geht fast immer mit einer niedrigen Conversion-Rate und einer kurzen Verweildauer einher. Das ist ein klares Signal für ungelöste Probleme aus Nutzersicht.

Die richtigen Werkzeuge sind dabei entscheidend. Die folgende Tabelle gibt Dir einen Überblick über die wichtigsten Analyse-Tools und ihre Funktion.

Übersicht der wichtigsten Analyse-Tools und ihre Funktion

Diese Tabelle zeigt, welche Werkzeuge für die Analyse des Nutzerverhaltens essenziell sind und wie sie, idealerweise gebündelt wie in alfima.io, zur Identifizierung von Optimierungspotenzialen beitragen.

| Werkzeug | Funktion | Typische Fragestellung |

|---|---|---|

| Web-Analyse (z. B. Google Analytics) | Liefert quantitative Daten zu Traffic, Absprungraten und Conversion-Pfaden. | "Auf welcher Seite verlieren wir die meisten Nutzer?" |

| Heatmaps | Visualisiert Klicks, Mausbewegungen und Scrolltiefen. | "Wird mein Call-to-Action-Button überhaupt gesehen und geklickt?" |

| Session-Recordings | Zeichnet anonymisierte Nutzersitzungen als Video auf. | "Warum bricht ein Nutzer den Kaufprozess genau an dieser Stelle ab?" |

| Umfragen & Feedback-Tools | Sammelt direktes, qualitatives Feedback von den Nutzern. | "Was hat Dich davon abgehalten, den Kauf abzuschließen?" |

Durch die Kombination dieser Tools erhältst Du ein umfassendes Bild, das weit über oberflächliche Metriken hinausgeht und Dir konkrete Ansatzpunkte liefert.

Benchmarks als Orientierung nutzen

Um Deine eigenen Zahlen besser einordnen zu können, hilft ein Blick auf branchenübliche Werte. Die durchschnittlichen Conversion Rates schwanken stark. Globale Vergleichsdaten für den deutschen Markt liegen oft zwischen 2,35 % und 5,31 %, während die Top-Performer Werte von über 11 % erreichen. Ein interessanter Fakt aus der Praxis: Landingpages mit weniger als 10 Elementen schneiden oft besser ab als überladene Seiten mit über 40 Elementen. Das bestätigt den Wunsch der Nutzer nach Klarheit. Mehr dazu findest Du in den aktuellen Statistiken zur Conversion-Rate-Optimierung auf amraandelma.com.

Dein Ziel sollte es sein, schrittweise die Hürden zu beseitigen, die Deine Nutzer vom Erreichen dieser Benchmarks abhalten. Manchmal sind es nicht große Designänderungen, sondern gezielte textliche Anpassungen, die den größten Einfluss haben. Wie Du solche Inhalte gezielt verbesserst, kannst Du in unserem Leitfaden über wirkungsvolle Content-Marketing-Strategien nachlesen.

Am Ende dieser Analysephase hast Du nicht nur eine Liste von Problemen, sondern ein tiefes Verständnis für die Perspektive Deiner Kunden. Du weißt genau, wo es hakt und hast erste Ideen, wie Du diese Reibungspunkte beseitigen kannst. Diese Erkenntnisse sind das Fundament für den nächsten Schritt: die Entwicklung wirksamer Hypothesen für Deine A/B-Tests.

Vom Bauchgefühl zur testbaren Hypothese: So entwickelst Du Gewinner-Ideen

Du hast jetzt tief in Deine Daten geschaut. Du weißt, wo es auf Deiner Webseite hakt und hast dank Heatmaps und Session-Recordings auch ein Gefühl dafür bekommen, warum Besucher an bestimmten Stellen den Faden verlieren oder abspringen. Super! Aber reine Daten sind eben nur das – Daten. Der wahre Wert entsteht erst jetzt, im nächsten Schritt: Wir müssen diese Erkenntnisse in konkrete, testbare Ideen verwandeln.

Ohne eine saubere Hypothese ist jede Optimierung ein reines Glücksspiel. Ein bisschen an der Farbe schrauben, ein Bild austauschen und hoffen, dass es was bringt. Das ist nicht nur ineffizient, sondern auch frustrierend. Ein strukturierter Ansatz sorgt dafür, dass jede Änderung auf einer handfesten, datengestützten Annahme beruht.

Von der Beobachtung zur Hypothese

Eine starke Hypothese ist weit mehr als nur eine vage Idee. Sie ist eine ganz spezifische, messbare und umsetzbare Aussage, die eine klare Ursache-Wirkungs-Beziehung beschreibt. Die goldene Regel, die ich mir über die Jahre angewöhnt habe, lautet: Formuliere Hypothesen immer nach dem Schema „Wenn wir [Änderung] umsetzen, dann wird [erwünschtes Ergebnis] eintreten, weil [Begründung].“

Diese simple Formel zwingt Dich, über die reine Änderung hinauszudenken und den psychologischen Hebel dahinter klar zu benennen.

Stellen wir uns das mal für einen Creator vor, der seine digitalen Produkte über eine Plattform wie alfima.io vertreibt.

-

Beobachtung: Ein Blick auf die Preisseite für einen Online-Kurs zeigt eine extrem hohe Absprungrate. Die Session-Recordings bestätigen den Verdacht: Besucher scrollen nervös zwischen den drei Preis-Paketen hin und her, klicken aber so gut wie nie auf einen der Kauf-Buttons. Die Seite wirkt überladen, und die Unterschiede zwischen den Paketen sind auf den ersten Blick einfach nicht klar genug.

-

Hypothese: Wenn wir das mittlere Paket visuell als „Beliebteste Wahl“ kennzeichnen und die Liste der Features pro Paket auf die drei wichtigsten Vorteile zusammenstreichen, dann wird die Klickrate auf den „Jetzt kaufen“-Button um 20 % steigen, weil wir die Qual der Wahl („Choice Overload“) für den Nutzer reduzieren und ihm eine klare Empfehlung an die Hand geben.

Siehst Du? Diese Hypothese ist spezifisch (Paket hervorheben, Features reduzieren), messbar (Klickrate um 20 % steigern) und liefert eine plausible Begründung (Entscheidungslast verringern). Solche Hypothesen sind Gold wert, denn sie lassen sich direkt – oft sogar ohne Programmierer – als A/B-Test umsetzen.

Ideenflut? So priorisierst Du mit dem PIE-Framework

Wahrscheinlich sprudelst Du nach der Analysephase nur so vor Ideen. Das ist großartig! Aber wo fängt man an? Welche Änderung verspricht den größten und schnellsten Erfolg? Um hier nicht nach Bauchgefühl zu entscheiden, nutze ich gerne ein einfaches, aber ungemein wirkungsvolles Modell: das PIE-Framework.

PIE steht für Potential, Importance, Ease (Potenzial, Wichtigkeit, Einfachheit). Du bewertest jede Deiner Hypothesen anhand dieser drei Kriterien auf einer Skala von 1 (niedrig) bis 10 (hoch).

- Potential (Potenzial): Wie viel Luft nach oben gibt es auf dieser Seite? Eine Landingpage mit einer miserablen Conversion-Rate hat natürlich ein viel höheres Verbesserungspotenzial als eine Seite, die bereits sehr gut performt.

- Importance (Wichtigkeit): Wie wertvoll ist der Traffic auf dieser Seite? Eine Änderung auf der Checkout-Seite (hohe Wichtigkeit) hat einen ungleich größeren Einfluss auf Deinen Umsatz als eine Optimierung der selten besuchten „Über uns“-Seite (geringe Wichtigkeit).

- Ease (Einfachheit): Wie einfach lässt sich der Test umsetzen? Eine reine Textänderung ist ein Kinderspiel (hoher Wert), während eine komplette Neugestaltung des Seitenlayouts viel Aufwand bedeutet (niedriger Wert).

Profi-Tipp: Berechne für jede Idee einen PIE-Score, indem Du die drei Werte addierst und durch 3 teilst (Potential + Importance + Ease / 3). So erhältst Du eine objektive Rangliste, die Dir hilft, Deine knappen Ressourcen genau dort einzusetzen, wo sie den größten Hebel haben.

Praktische Beispiele für starke Hypothesen

Um das Ganze noch greifbarer zu machen, hier ein paar weitere Beispiele, direkt aus der Welt der digitalen Produkte:

| Szenario | Beobachtung aus der Analyse | Hypothese |

|---|---|---|

| Verkauf eines E-Books | Nutzer scrollen zwar auf der Landingpage, ignorieren aber die wichtigen Testimonials ganz am Ende. | Wenn wir ein starkes, kurzes Testimonial direkt unter der Hauptüberschrift platzieren, steigern wir die Conversion-Rate, weil wir sofort Vertrauen (Social Proof) aufbauen. |

| Anmeldung zum Trial für eine Software | Die Anmelderate auf Mobilgeräten ist 50 % niedriger als auf dem Desktop. | Wenn wir das Anmeldeformular auf dem Handy über den sichtbaren Bereich („above the fold“) schieben, erhöhen wir die Anmelderate, weil die wichtigste Aktion sofort sichtbar ist. |

| Buchung eines Coaching-Calls | Viele Interessenten besuchen die Buchungsseite, brechen aber ab, sobald sie den vollen Kalender mit Dutzenden Optionen sehen. | Wenn wir statt des kompletten Kalenders nur die nächsten drei verfügbaren Termine prominent anzeigen, steigern wir die Buchungen, weil wir die Komplexität reduzieren und eine sanfte Dringlichkeit erzeugen. |

Diese Beispiele zeigen den Weg: von einer qualitativen Beobachtung hin zu einem messbaren Experiment. Anstatt zu raten, was funktionieren könnte, testest Du gezielt psychologische Prinzipien wie Social Proof, Einfachheit oder Dringlichkeit. Genau dieser strukturierte Prozess ist der Kern, um Deine Conversion-Rate systematisch in die Höhe zu schrauben. Mit einer klaren Hypothese in der Tasche bist Du jetzt bestens für den nächsten, entscheidenden Schritt gewappnet: den eigentlichen A/B-Test.

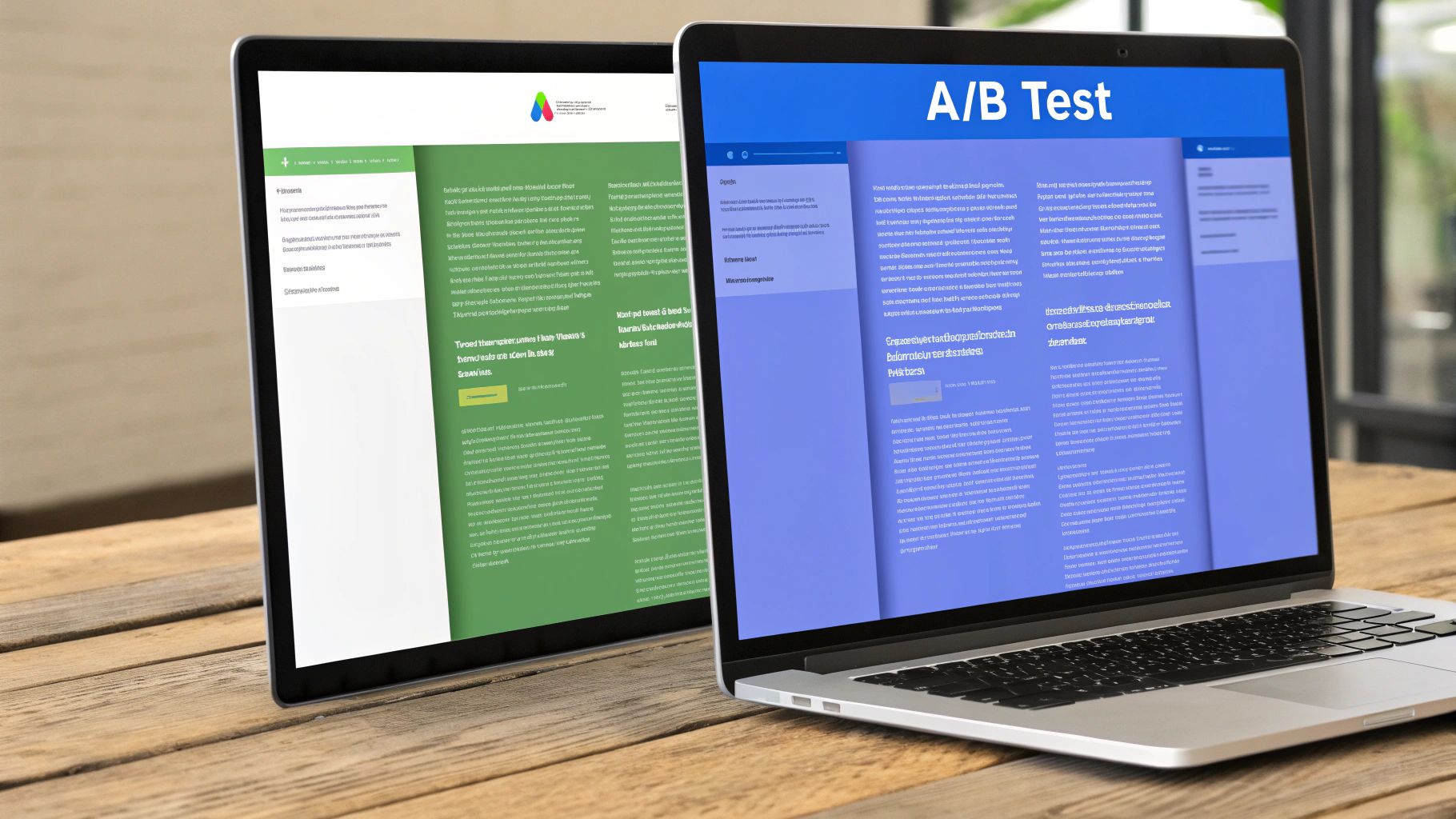

So klappt Dein erster A/B-Test auf Anhieb

Okay, die Analyse ist durch und Du hast eine starke Hypothese in der Tasche. Jetzt wird's praktisch! Viele Creator schrecken vor Begriffen wie „A/B-Test“ erst einmal zurück, weil es furchtbar technisch und kompliziert klingt. Die gute Nachricht? Mit den richtigen Werkzeugen ist das Ganze viel einfacher als gedacht. Ich führe Dich hier durch den gesamten Prozess, Schritt für Schritt.

Das eigentliche Ziel ist, Deine Hypothese unter realen Bedingungen zu testen. Schluss mit dem Rätselraten. Stattdessen lassen wir Deine Besucher darüber abstimmen, welche Version Deiner Seite sie wirklich überzeugt.

Welche Testmethode ist die richtige für Dein Projekt?

Bevor es losgeht, sollten wir kurz über die verschiedenen Testarten sprechen. Jede Methode hat ihre eigenen Stärken und passt zu unterschiedlichen Situationen, gerade wenn Du digitale Produkte verkaufst.

-

Der A/B-Test (oder Split-Test): Das ist der Klassiker und für den Einstieg absolut perfekt. Du erstellst eine Variante (Version B) Deiner bestehenden Seite (Version A) und änderst dabei nur ein einziges Element. Das kann die Überschrift sein, der Text auf einem Button oder ein Bild. Der Traffic wird dann fair, also 50/50, auf beide Versionen verteilt. Am Ende siehst Du schwarz auf weiß, welche Variante besser funktioniert.

-

Der A/B/n-Test: Im Grunde eine Erweiterung des A/B-Tests. Hier testest Du einfach mehr als nur eine Variante. Du könntest zum Beispiel drei völlig verschiedene Überschriften (A vs. B vs. C) ins Rennen schicken, um den klaren Gewinner zu finden.

-

Der Multivariate Test (MVT): Diese Methode ist schon etwas für Fortgeschrittene und macht eigentlich nur bei sehr hohem Traffic Sinn. Hier werden mehrere Änderungen gleichzeitig in verschiedenen Kombinationen getestet (z. B. zwei Überschriften und drei Button-Farben). Das System findet dann heraus, welche Kombination die beste Performance liefert.

Für den Anfang ist der klassische A/B-Test die beste Wahl. Er ist unkompliziert aufzusetzen, die Ergebnisse sind glasklar und Du lernst schnell, welche kleinen Schrauben die größte Wirkung haben.

Ein Beispiel aus der Praxis: Eine neue Überschrift testen

Stellen wir uns folgendes Szenario vor: Du bietest über alfima.io eine Software an und willst die Anmelderate für den kostenlosen Trial auf Deiner Landingpage ankurbeln. Deine Hypothese könnte lauten: „Wenn wir die Überschrift von ‚Starte jetzt Deinen kostenlosen Trial‘ zu ‚Teste alle Premium-Features 14 Tage unverbindlich‘ ändern, steigern wir die Anmeldungen. Warum? Weil die neue Headline den Nutzen konkreter macht und die Angst vor einer Verpflichtung nimmt.“

So ein Test lässt sich mit einer modernen All-in-One-Plattform wie alfima.io wirklich kinderleicht umsetzen, da alle nötigen Werkzeuge schon an Bord sind.

-

Variante B im visuellen Editor bauen: Mit nur einem Klick duplizierst Du Deine bestehende Landingpage (Version A). In der neuen Kopie (Version B) änderst Du jetzt ausschließlich die Überschrift, so wie es Deine Hypothese vorgibt. Alle anderen Elemente – Bilder, Texte, Button-Farbe – bleiben exakt gleich. Das ist extrem wichtig, denn nur so kannst Du sicher sein, dass am Ende wirklich die Überschrift für den Unterschied verantwortlich ist.

-

Traffic-Aufteilung festlegen: Du stellst den Test so ein, dass 50 % Deiner Besucher automatisch die alte Version und die anderen 50 % die neue Version sehen. Gute Tools sorgen dafür, dass wiederkehrende Besucher immer dieselbe Variante sehen, um die Ergebnisse nicht zu verfälschen.

-

Conversion-Ziel definieren: Woher soll das System wissen, wann es erfolgreich war? Du musst ihm ein Ziel geben. In unserem Fall wäre das Ziel der Klick auf den „Jetzt testen“-Button oder das Erreichen der „Danke“-Seite nach einer erfolgreichen Anmeldung.

Die häufigsten Stolperfallen – und wie Du sie elegant umgehst

Ein Test ist immer nur so gut wie seine Durchführung. Es gibt ein paar klassische Fehler, die ich immer wieder sehe und die jedes Ergebnis unbrauchbar machen können. Achte von Anfang an darauf, diese zu vermeiden.

Fehler 1: Den Test viel zu früh beenden

Es ist unheimlich verlockend: Eine Variante liegt nach zwei Tagen vorn und man möchte den Test am liebsten sofort beenden und den Sieger küren. Tu das nicht! Das Nutzerverhalten am Wochenende kann sich dramatisch von dem unter der Woche unterscheiden.

- Faustregel: Lass einen Test mindestens eine, besser zwei volle Wochen laufen. So bildest Du einen kompletten Geschäftszyklus ab. Noch wichtiger ist aber die statistische Signifikanz. Dieser Wert sagt aus, wie wahrscheinlich es ist, dass Dein Ergebnis kein reiner Zufall ist. Ein aussagekräftiger Test sollte eine Signifikanz von mindestens 95 % erreichen. Moderne Tools wie in alfima.io zeigen Dir diesen Wert praktischerweise live an.

Fehler 2: Zu viele Änderungen auf einmal testen

Stell Dir vor, Du änderst in Variante B die Überschrift, das Hauptbild und den Button-Text. Die Variante gewinnt haushoch – super! Aber woran lag es jetzt genau? Du hast keine Ahnung. Du hast zwar eine bessere Seite, aber nichts für die Zukunft gelernt.

- Faustregel: Halte Dich eisern an die Regel: Ein Test, eine Änderung. Nur so isolierst Du den einen Hebel, der wirklich den Unterschied gemacht hat.

Fehler 3: Externe Einflüsse ignorieren

Läuft parallel zu Deinem Test eine große Rabattaktion? Ein Feiertags-Special? Oder geht zufällig einer Deiner Social-Media-Posts viral? Solche Ereignisse können das Verhalten Deiner Besucher massiv beeinflussen und die Testergebnisse komplett verfälschen.

- Faustregel: Plane Deine Tests am besten für Phasen mit „normalem“ Traffic. Dokumentiere alle Marketingaktionen, die nebenher laufen, um die Ergebnisse später richtig einordnen zu können.

Wenn Du diese Punkte beachtest, liefern Deine A/B-Tests verlässliche Daten. So baust Du Schritt für Schritt ein tiefes Verständnis dafür auf, was Deine Zielgruppe wirklich antreibt, und optimierst Deine Conversion-Rate – nicht durch Raten, sondern durch echtes Wissen.

Testergebnisse richtig interpretieren und nutzen

Okay, Dein A/B-Test ist durchgelaufen, die Zahlen sind da und Variante B hat gewonnen – super! Aber bevor Du jetzt einfach den Schalter umlegst und die neue Version für alle live schaltest, beginnt die eigentliche Arbeit: die Ergebnisse wirklich zu verstehen. Ein einfacher Sieg an der Oberfläche kratzt oft nur an der halben Wahrheit. Wenn Du Deine Conversion Rate nachhaltig steigern willst, musst Du herausfinden, warum die neue Version besser ankam.

Schau über die Gesamt-Conversion-Rate hinaus. Die wirklich spannenden Erkenntnisse verbergen sich oft in den Details. Indem Du Deine Ergebnisse in kleinere Gruppen aufteilst, also segmentierst, entdeckst Du erst die wahren Muster.

Ein Testergebnis ist keine Endstation. Es ist der Startschuss, um tiefer zu graben. Jede erfolgreiche Änderung verrät Dir etwas unglaublich Wertvolles über Deine Zielgruppe, das Du für alle zukünftigen Kampagnen und Produkte nutzen kannst.

Tiefer graben mit Segmentierung

Die durchschnittliche Conversion Rate kann täuschen. Entscheidend ist, wie sich verschiedene Nutzergruppen verhalten haben. Vielleicht hat Deine neue, mutige Überschrift auf dem Desktop eingeschlagen wie eine Bombe, aber mobile Nutzer eher abgeschreckt. Solche Details sind Gold wert.

Diese Segmentierungen liefern fast immer wertvolle Einblicke:

- Nach Gerätetyp: Hat die Änderung auf dem Smartphone genauso gut funktioniert wie auf dem Desktop? Responsive Design ist eben mehr als nur die technische Anpassung der Bildschirmgröße; es geht um den Nutzungskontext.

- Nach Traffic-Quelle: Haben Besucher von Deiner E-Mail-Liste anders reagiert als Nutzer, die über eine Social-Media-Anzeige kamen? Das verrät Dir eine Menge über die Erwartungshaltung des jeweiligen Kanals.

- Nach neuen vs. wiederkehrenden Besuchern: Manchmal überzeugt eine Änderung Neukunden sofort, während Deine treuen Stammkunden irritiert sind. Beides ist eine wichtige Erkenntnis für die Zukunft.

Eine Untersuchung zu Traffic-Quellen in Deutschland hat beispielsweise gezeigt, dass direkter Traffic mit durchschnittlich 3,3 % die höchsten Conversion Rates erzielt, dicht gefolgt von der bezahlten Suche mit 3,2 %. Diese Zahlen machen klar, dass es sich lohnt, die Kanäle differenziert zu betrachten, da der Traffic von dort oft schon eine hohe Kaufabsicht mitbringt. Mehr spannende Statistiken zur Conversion-Rate-Optimierung findest Du in diesem Artikel auf bloggingwizard.com.

Vom Test zum nachhaltigen Wissen

Wenn eine Variante klar gewonnen hat und auch die Segmentanalyse keine Warnsignale zeigt, ist es Zeit, die Änderung dauerhaft zu implementieren. Doch damit ist der Prozess nicht abgeschlossen. Um den Optimierungskreislauf wirklich zu schließen, musst Du das, was Du gelernt hast, festhalten und für zukünftige Entscheidungen nutzbar machen.

Richte eine interne Wissensdatenbank oder ein einfaches geteiltes Dokument ein, in dem Du jeden Test festhältst:

- Die Hypothese: Was war unsere ursprüngliche Annahme?

- Das Ergebnis: Welche Variante hat gewonnen und mit welchem prozentualen Uplift?

- Die wichtigste Erkenntnis: Was haben wir über unsere Kunden gelernt? (z. B. „Unsere Kunden reagieren extrem positiv auf konkrete Zahlen im Nutzenversprechen.“)

Plattformen wie alfima.io können diesen Prozess super unterstützen, da Du dort nicht nur Tests durchführen, sondern auch die Ergebnisse und Learnings zentral speichern kannst. So baust Du nach und nach ein tiefes, datenbasiertes Verständnis dafür auf, was Deine Kunden wirklich wollen und was nicht.

Dieses Wissen ist die Grundlage für jeden zukünftigen Online-Shop für digitale Produkte, den Du aufbaust, oder jede Marketingkampagne, die Du planst. So stellst Du sicher, dass jede neue Maßnahme auf den Erfolgen der Vergangenheit aufbaut.

Häufige Fragen zur Conversion-Rate-Optimierung

Wer sich intensiv mit der Optimierung digitaler Produkte beschäftigt, stößt früher oder später auf dieselben Hürden. Gerade als Creator oder Experte will man sichergehen, dass die eigenen Anstrengungen auch Früchte tragen. Hier beantworte ich die Fragen, die mir in der Praxis am häufigsten begegnen, und gebe Dir praxiserprobte Tipps an die Hand.

Wie lange sollte ein A/B-Test eigentlich laufen?

Das ist eine der wichtigsten Fragen überhaupt. Ein Fehler, den ich immer wieder sehe, ist, dass Tests viel zu früh abgebrochen werden – meistens, sobald eine Variante leicht die Nase vorn hat. Das ist ein fataler Trugschluss, denn das Nutzerverhalten schwankt oft stark.

Ein guter A/B-Test braucht Zeit, bis er wirklich aussagekräftig ist. Konkret müssen zwei Kriterien erfüllt sein:

- Statistische Signifikanz: Das ist im Grunde Dein Sicherheitsnetz gegen den reinen Zufall. Erst ab einer Signifikanz von mindestens 95 % kannst Du davon ausgehen, dass der gemessene Unterschied wirklich auf Deine Änderung zurückzuführen ist und nicht nur eine Laune des Moments war.

- Genügend Conversions: Jede Variante muss eine solide Basis an Conversions aufweisen. Eine bewährte Faustregel ist, mindestens 100 Conversions pro Variante abzuwarten. Das sorgt für stabile und verlässliche Ergebnisse.

Ganz wichtig ist auch, den Test über einen kompletten Geschäftszyklus laufen zu lassen. Das bedeutet in der Regel, ihn mindestens eine, besser sogar zwei volle Wochen aktiv zu lassen. So fängst Du die natürlichen Schwankungen im Nutzerverhalten zwischen Wochentagen und dem Wochenende ab.

Moderne Plattformen wie alfima.io machen es Dir hier zum Glück leicht. Sie berechnen die statistische Signifikanz laufend und geben Dir ein klares Signal, sobald Dein Test belastbare Daten liefert.

Was, wenn ein Test kein klares Ergebnis bringt?

Ein uneindeutiges oder sogar negatives Testergebnis fühlt sich erstmal wie ein Rückschlag an. Ist es aber nicht! In Wahrheit hast Du gerade etwas unglaublich Wertvolles gelernt.

Es bedeutet ganz einfach, dass Deine Hypothese nicht gestimmt hat – die Änderung hat die Nutzer entweder kaltgelassen oder sogar gestört. Das ist kein Grund für Frust, ganz im Gegenteil: Du hast Dich gerade davor bewahrt, eine Änderung dauerhaft zu übernehmen, die Deine Conversion-Rate im schlimmsten Fall gesenkt hätte.

Dokumentiere dieses Learning. Halte fest, was Du vermutet und was Du getestet hast und was das Ergebnis war. Dann schnappst Du Dir die nächste Hypothese von Deiner Prioritätenliste. Oft sind es nicht die großen Design-Revolutionen, die den Hebel umlegen, sondern kleine, durchdachte Anpassungen am Text oder an der Nutzerführung.

Kann ich die Conversion-Rate auch mit wenig Traffic optimieren?

Ja, absolut! Viel Traffic macht A/B-Tests natürlich schneller, aber auch mit einer kleineren Besucherzahl ist Optimierung nicht nur möglich, sondern extrem sinnvoll. Der Prozess dauert eben nur etwas länger, bis Du die nötige statistische Sicherheit erreichst.

Bei begrenztem Traffic musst Du einfach cleverer priorisieren. Konzentriere Dich auf Tests mit dem größtmöglichen Hebel. Das sind meistens Änderungen an den wichtigsten Stationen Deiner Customer Journey, zum Beispiel:

- Deine Preisseite

- Der Checkout-Prozess

- Deine wichtigste Landingpage

Alternativ kannst Du den Fokus stärker auf qualitative Methoden legen. Statt großer A/B-Tests liefern Dir Session-Recordings oder gezielte Nutzerumfragen oft Gold wert. Solche Funktionen sind oft direkt in Tools wie alfima.io integriert und decken schnell offensichtliche Hürden oder Usability-Probleme auf. Solche "Quick Wins" kannst Du dann oft direkt umsetzen, ohne einen langwierigen Test starten zu müssen.

Ein weiterer Hebel ist die Zusammenarbeit mit Partnern. Wenn es Dir gelingt, mehr qualifizierten Traffic auf Deine Seite zu lenken, beschleunigst Du natürlich auch Deine Tests. Wie Du ein solches Netzwerk aufbaust, erklären wir in unserem Leitfaden zum Thema Affiliate-Marketing für Anfänger.

Wie viele Tests sollte ich gleichzeitig durchführen?

Für die allermeisten Unternehmen – und ganz besonders für Creator und Solopreneure – ist die Antwort glasklar: Führe immer nur einen einzigen Test pro Seite zur gleichen Zeit durch.

Wenn mehrere Tests auf derselben Seite laufen, können sich die Änderungen gegenseitig kannibalisieren. Am Ende weißt Du nicht mehr, welche Anpassung für den Erfolg (oder Misserfolg) verantwortlich war. Dieser "Interaktionseffekt" macht Deine hart erarbeiteten Learnings wertlos.

Fokussiere Dich. Führe einen Test sauber durch, werte ihn aus, setze den Gewinner um und starte erst dann den nächsten. Dieser disziplinierte Ansatz ist der einzige Weg, um verlässliche Erkenntnisse zu gewinnen, die Dein Business wirklich voranbringen.

Du siehst, Conversion-Optimierung ist kein Hexenwerk, sondern ein systematischer Prozess. Mit den passenden Werkzeugen und einer klaren Strategie kannst Du aus Deinen bestehenden Besuchern deutlich mehr Kunden machen. alfima.io wurde genau dafür entwickelt und vereint Analyse, A/B-Testing und den Verkauf digitaler Produkte auf einer einzigen Plattform. Mach Dir selbst ein Bild und starte Deine kostenlose 14-tägige Testphase.